Sowohl die vorgestellten Big-Data-Technologien als auch Data-Warehouses, die im Folgenden näher beschrieben werden, dienen als Grundlage für Datenanalysen. In diesem Zusammenhang wird die Datenanalyse, die auf Data-Warehouses aufbaut, genannt Business Intelligence, ebenfalls vorgestellt. Eine Abgrenzung der beiden Konzepte ermöglicht es anschließend, auch Potenziale und Herausforderungen im Rahmen von Big-Data besser von denen bekannter Strukturen zu unterscheiden.

Business Intelligence (BI) befasst sich mit der Erfassung und Auswertung von Daten (Müller 2013, S. 12) und der Umwandlung von Informationen in Wissen (Schön 2016, S. 291; Hannig 2008, S. 77) und dient somit als Managementstrategie zur strukturierten und effizienten Entscheidungsfindung (Nelson 2010, S. 2). Dieses Konzept existiert bereits seit über 10 Jahren und basiert bei analytischen Daten auf einer dafür konzipierten Datenbank, dem sogenannten Data-Warehouse (DWH) (Schön 2016, S. 291). Dieses integriert die aus internen Geschäftsprozessen und externen Quellen gesammelten Daten in einem gemeinsamen System und dient gleichzeitig als Datenauswertungsplattform. Der Vorteil einer solchen Architektur liegt darin, dass die Analysen der Daten nicht in den operativen Systemen (z.B. Enterprise-Resource-Planning (ERP), Customer-Relationship- Management (CRM) oder Supply-Chain-Management (SCM)) selbst durchgeführt werden und somit die Performanz gesteigert wird, da die regulären Geschäftsprozesse nicht zu stark belastet werden. (Müller 2013, S. 13)

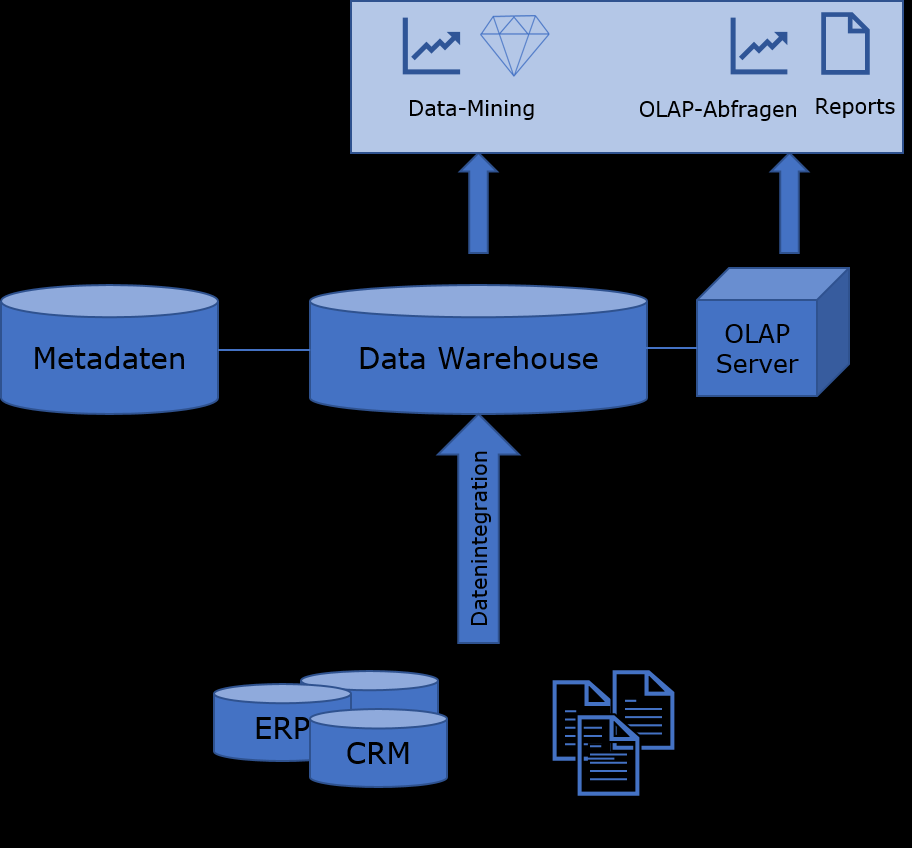

Abbildung 2 zeigt ein vereinfachtes Data-Warehouse Konzept. Zuerst werden Daten aus unterschiedlichen Quellen über den ETL (Extract, Transform, Load) Prozess im Data- Warehouse gespeichert und dessen Metadaten im sogenannten Repositorium. Zur Auswertung der Daten wird ein Online Analytical Processing (OLAP) Server verwendet, der die eigentliche Analyse der Daten durchführt. Die Ergebnisse der OLAP-Abfragen zeichnen sich durch ihre gruppierte und aggregierte Form aus und richten sich an Führungskräfte zur Entscheidungsunterstützung. Neben OLAP-Abfragen können auch weitere Analysemethoden, wie Data-Mining angewendet werden. (Müller 2013, S. 13) Müller beschreibt Data-Mining als das „semi-automatische Aufdecken von Mustern mittels Datenanalyse- Verfahren in meist sehr großen Datenbeständen“ (Müller 2013, S. 75), bildet also den Übergang zu Big-Data-Analysen ab.

Durch Business Intelligence erhalten Unternehmen beispielsweise Informationen über ihre Produkte, Lagerbestände, Kunden und Branchenangaben (Chen 2010, S. 2). Außerdem werden die Daten interner Betriebsprozesse vom BI-System gesammelt und analysiert, sodass Vorschläge für die Verbesserung von Prozessen und somit Grundlagen für Entscheidungen und Aktionen im Unternehmen ermöglicht werden (King 2014, S. 38). Generell zeichnen sich DWH durch die Analyse historischer Daten aus und besitzen Antwortzeiten, die in einem Zeitraum von weniger Sekunden bis einigen Minuten liegen können, je nach Komplexität der Analysen. (Müller 2013, S. 13)

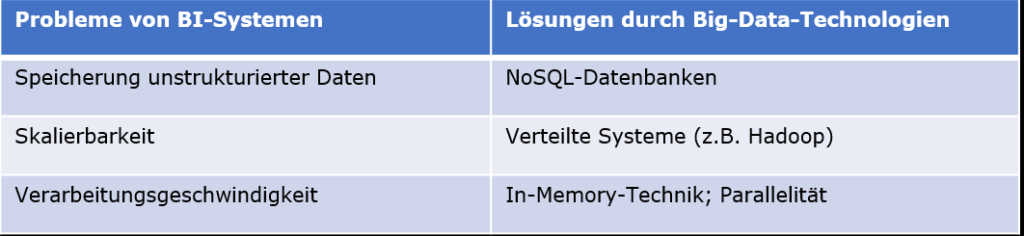

Da die Zahl der Informationssysteme in Unternehmen ansteigt, werden auch die zu bearbeitenden Daten umfangreicher. Neben internen Unternehmensdaten gewinnen auch unstrukturierte Daten für Unternehmen an Bedeutung und somit steigt das Datenvolumen in Unternehmen weiterhin deutlich an und erreicht das Gebiet von Big-Data. Daraus ergeben sich technische Nachteile in BI-Systemen, die von Big-Data-Technologien überwunden werden können. (Schön 2016, S. 318) Die folgende Tabelle zeigt Probleme von BI-Systemen und Lösungen durch vorgestellte Big-Data-Technologien auf:

(in Anlehnung an Bitkom 2014, S. 35)

Relationale Datenbanken und auch OLAP-Datenbanken, die in Data-Warehouse-Systemen eingesetzt werden, stoßen beim Volumen und der teils unstrukturierten Form der Daten an ihre Grenzen, da die Konsistenzsicherung durch die relationale Datenhaltung nach den ACID-Kriterien die Performanz einschränkt. (Schön 2016, S. 318) Um dieses Problem zu umgehen, können stattdessen NoSQL-Datenbanken (vgl. 2.2.2.1) verwendet werden.

Eine mangelnde Skalierbarkeit über Rechnergrenzen hinweg besteht ebenfalls bei BISystemen. Dadurch können steigende Datenmengen nicht effizient gehandhabt werden. (Schön 2016, S. 318). Systeme wie Hadoop bieten die Möglichkeit, die Datenspeicherung- und Verarbeitung auf ganze Rechnernetze zu verteilen und somit Skalierbarkeit zu gewährleisten (vgl. 2.2.3) (Bitkom 2014, S. 35–36).

Eine weitere technische Herausforderung liegt darin, trotz steigenden Datenvolumens die Ergebnisse in der gleichen Zeit zu produzieren. Sinnvolle Arbeitszeiten lassen sich dann erreichen, wenn viele Rechner in einem Verbund parallel an der Aufgabe arbeiten. (Bitkom 2014, S. 38–39) Diese Möglichkeit bietet sich bei verteilten Systemen, die nach der sogenannten Shared-Nothing-Architektur arbeiten, bei der alle Rechner unabhängig voneinander ihre Aufgaben erfüllen. Die daraus resultierenden Ergebnisse sind jedoch umfangreich und müssen weiterer Verarbeitung unterzogen werden, um eine detaillierte Analyse zu erhalten. Des Weiteren kann die In-Memory-Technik verwendet werden, um durch die schnellere Lesegeschwindigkeit aus dem Hauptspeicher Zeit bei der Bearbeitung zu sparen.

Die hier gezeigten Nachteile verdeutlichen die Grenzen zwischen Big-Data und Data- Warehouses. Um dem 4V-Modell von Big-Data gerecht zu werden reichen die Strukturen von DWH-Systemen nicht aus. Besonders die Dimensionen Datenvielfalt und Datenvolumen bilden die Hauptprobleme klassischer DWH-Architekturen. Auch wenn erste Versuche unternommen werden, XML-Dokumente so aufzubereiten, sodass ihre unstrukturierte Form überwunden wird und sie in relationalen Datenbanken gespeichert werden können, ist dies nur ein Anfang und betrifft nicht die zahlreichen anderen Typen von unstrukturierten Daten wie beispielsweise Sensordaten. (Grossmann und Rinderle-Ma 2015, S. 96)

Obwohl sich die DWH-Systeme im Laufe der Zeit weiterentwickeln und neue Technologien, beispielsweise zur angesprochenen XML-Dokument Integration entwickelt werden, wird deutlich, dass die gezeigten Probleme (vgl. Tabelle 3), die mit den 4V in Verbindung gebracht werden können, bisher nur durch Big-Data-Technologien bewältigt werden können. Unter dem Begriff Business Intelligence 2.0 oder Explorative Business Intelligence werden einige dieser Technologien wie die In-Memory-Technik im Kontext von Business Intelligence inzwischen in gemeinsamen Architekturen vereint (Nelson 2010, S. 3; Schön 2016, S. 311–312). Das bedeutet, in der Praxis können sich Big-Data und DWH ergänzen und zusammen die Wertschöpfung verbessern (Sharda et al. 2017, S. 393–395)

Recent Comments